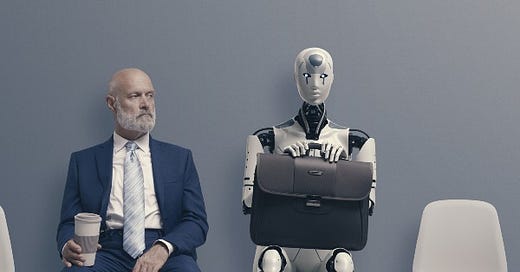

Alors que le sommet de l’IA débute à Paris, on peut observer trois types de réactions à la technologie :

(1) Blasé : l’IA serait un perroquet sophistiqué qui peut se substituer au bullshit mais apporte peu du point de vue de la productivité car on a toujours besoin d’un humain pour repasser derrière. C’est le point de vue de Daron Acemoglu, “prix Nobel d’économie” 2024, au moins à moyen-terme : “Comme je l’ai écrit [dans la revue Economic Policy], il ne faut pas s’attendre à ce que beaucoup plus de 5 % des tâches humaines soient remplacées par l’IA au cours des dix prochaines années. Les modèles d’IA ont besoin de bien davantage de temps pour acquérir les capacités de discernement, le raisonnement et les facultés sociales nécessaires dans la plupart des emplois.” (Le Monde, 2024) Selon ce point de vue l’IA serait partout sauf… dans les chiffres de productivité.

(2) Enthousiaste : l’IA apporterait des gains de productivité très importants. C’est le point de vue en France par exemple de Xavier Jaravel, prix du meilleur jeune économiste 2021 : “Les études ont documenté les effets de l’IA sur la productivité dans des contextes très différents : chez les consultants, les avocats, et les agents de services d’assistance clientèle. Dans ces trois cas, les chercheurs documentent de forts gains de productivité, notamment pour les salariés qui étaient, à la base, les moins performants, ce qui réduit les inégalités au sein des entreprises” (Les Échos, 2025).

(3) (Très très) Inquiet : l’IA poserait un risque existentiel allant jusqu’à l’extinction humaine si les IA deviennent plus intelligentes que ses créateurs (singularité). Ce point de vue a notamment été exprimé par … Elon Musk qui en 2023 réclame, parmi d’autres, une pause dans le développement de l’intelligence artificielle : “Devons-nous laisser les machines inonder nos canaux d’information de propagande et de mensonges ? Devrions-nous automatiser tous les emplois, y compris ceux qui sont gratifiants ? Devons-nous développer des esprits non humains qui pourraient un jour être plus nombreux, plus intelligents, et nous remplacer ? ». Elon Musk a apparemment changé d’avis et semble penser que quitte à aller vers une catastrophe, autant que cela soit lui qui la crée.

Comment trancher ? Ces points de vue ne sont pas nécessairement contradictoires, ils éclairent des aspects différents qui peuvent coexister et qu’il n’est pas forcément possible de trancher aujourd’hui de façon empirique. Le fait que les entreprises qui utilisent l’IA soient plus compétitives n’est contradictoire ni avec une absence de gains de productivité dans l’économie, ni avec une forte dégradation du débat public.

Partons des études dont parle Xavier Jaravel.

L'analyse est explicitement partielle. L'effet de l'IA sur l'emploi des entreprises qui utilisent l'IA est positif... car ces entreprises gagnent des parts de marché sur celles qui n'utilisent pas l'IA : “En somme, les entreprises et les pays qui vont négocier au mieux la révolution de l’IA sont ceux qui parviendront à adopter ces technologies plus rapidement. Ils accroissent ainsi leurs parts de marché et préservèrent mieux l’IA. Le risque principal n’est donc pas de se faire “remplacer” par l’IA, mais plutôt par un concurrent qui utilise l’IA, dans le même pays ou à l’étranger”.

Ce raisonnement fait face à deux difficultés potentielles. Premièrement, il compare les entreprises qui utilisent l’IA et celles qui ne l’utilisent pas. Mais ces entreprises ne diffèrent pas que par l’IA. Si ce biais de sélection est mal contrôlé, les études vont avoir tendance à surestimer l’impact de l’investissement dans l’innovation (car les entreprises qui investissent dans l’innovation ont probablement des avantages inobservables non négligeables par rapport à celles qui n’investissent pas).

Deuxièmement, ce type de raisonnement ne dit pas ce qui va se passera si tout le monde utilise l’IA (ou quand tout le monde utilisera l'IA puisque si les gains relatifs de productivité sont réels, tout le monde s’y ralliera).

Existe-t-il des gains globaux ? Si les entreprises qui adoptent l'IA gagnent des parts de marché, très probablement... à moins que l'utilisation de l'IA ait une forte externalité négative, plus forte que l'augmentation de la compétitivité. Je pense que c'est cet aspect que des personnes inquiètes redoutent aujourd'hui, et qui n'apparait pas dans les études que citent Jaravel, qui s'en tiennent à la compétitivité.

Il me semble que dans le passé, les nouvelles technologies ont été régulé de sorte que les externalités négatives ont été maitrisées et que l'on peut conclure contre les Luddites : "on n'arrête pas le progrès". Mais il est possible que “cette fois, c’est différent” (pour reprendre le titre ironique de Reinhart et Rogoff). Je vois deux problèmes potentiels :

(a) il est possible, voire probable aujourd'hui, que ceux qui contrôlent l'IA contrôlent aussi les gouvernements qui régulent les IA. La capture préventive du régulateur pourrait annihiler toute régulation.

(b) il y a une possibilité nouvelle d' "Enshittification" si tout le monde adopte une technologie qu'il ne maitrise pas, qui marche comme une boite noire. C’est ce que les inquiets soulignent lorsqu’ils ont peur que les machines “inondent nos canaux d’information de propagande et de mensonges”. Ce mythe de la perte d'autonomie de l'homme par la technologie est très ancien...mais la question mérite d’être reposée aujourd’hui car le mécanisme est particulièrement adapté à l'IA qui contrairement à l'électricité ou l'ordinateur fonctionne comme une boite noire, de façon non transparente, et pas que pour l'utilisateur mais aussi pour ses concepteurs. Certes je ne sais pas comment fonctionne exactement le moteur de ma voiture, mais le mécanicien au coin de la rue le sait. C’est très différent des algorithmes de X (qui font l’objet d’une plainte sur ce thème). Ce n'est pas qu'une question théorique : on a tous une expérience de l'utilisation d'algorithmes qui individuellement permettent de la fluidité mais collectivement aboutissent à des résultats problématiques pour tous. Ce sont ces algorithmes qui ont peut-être porté Trump et Musk au pouvoir (mais c'est aussi éventuellement grâce à eux que vous me lisez).

Aussi, la question des inégalités doit se reposer. Xavier Jaravel est optimiste et conclue à une possible réduction des inégalités : dans les études mentionnées, les gains de productivité sont supérieures pour les individus les moins performants initialement. Mais ces études s'appuient surtout sur l'analyse de tâches individuelles. Dans nos sociétés, les tâches sont généralement accomplies en groupe (surtout dans les métiers impactés par l'IA). Dans ce contexte, les plus performants n'ont généralement pas les mêmes tâches que les moins performants car ils encadrent. On peut penser que l'IA renforce la demande d'encadrement et donc augmente les inégalités entre managers et non-managers. Aussi, si l'IA augmente la compétitivité des entreprises mais pas la productivité globale, cela devrait se faire au bénéfice des actionnaires des entreprises compétitives par rapport aux salariés (qui font face à un marché du travail relativement concurrentiel). Encore une fois le passage de l'observation micro aux effets macros n'est pas évident.

Une expérience individuelle satisfaisante ne présume pas d'un progrès collectif. On ne peut se satisfaire d'un "faisons-le puisque tout le monde le fait et a l'air de mieux se porter" sans réflexion collective sur les normes et valeurs que nous voulons garder.